Es ist echt beeindruckend, dass ChatGPT Texte erzeugen kann, die wie von Menschen verfasst klingen. Doch wie schafft es das? Und warum funktioniert es so gut? Nun, ich möchte dir einen kurzen Einblick geben, wie ChatGPT arbeitet. Ich halte mich hier nicht mit zu technischen Details auf. Wenn du die Funktionsweise von ChatGPT genauer verstehen willst und dich tiefgründig damit auseinandersetzen willst empfehle ich dir den Aufsatz von Stephen Wolfram unter diesem Link (Auf englisch aber mit abstand der beste und detaillierteste Aufsatz dazu, wie Die KI hinter ChatGPT funktioniert.)

ChatGPT ist ein „Large Language Modell“ (LLM) Zu deutsch „Großes Sprach Modell“.

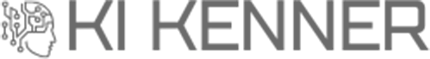

ChatGPT versucht im Grunde genommen, einen logischen Fortsatz zu dem bisher eingegebenen Text (Dem Prompt) zu liefern. Du kannst dir das so vorstellen: Wenn man den Satzanfang „Ich mag …“ hat, durchsucht ChatGPT Milliarden von Seiten, mit denen es Trainiert wurde und schaut, wie dieser Satz in den meisten Fällen weitergehen würde. Statt den genauen Text zu suchen, sucht es nach Dingen, die im Kontext ähnlich sind und bestimmt dann, welches am wahrscheinlichsten das nächste Wort wäre

ChatGPT „berechnet” also, auf Basis all der Texte, die es gelesen hat, was das wahrscheinlichste, nächste Wort ist. Und hier wird es spannend: Statt immer das wahrscheinlichste Wort zu wählen, nimmt es manchmal auch ein weniger wahrscheinliches Wort. Das macht den Text interessanter.

Kurz gesagt, ChatGPT ist wie ein genialer Schriftsteller, der sich von allem inspirieren lässt, was er jemals gelesen hat. Aber er hat auch seine kleinen Geheimnisse und Überraschungen, die den Text spannend und einzigartig machen können.

Feineinstellungen der Ausgabe von ChatGPT

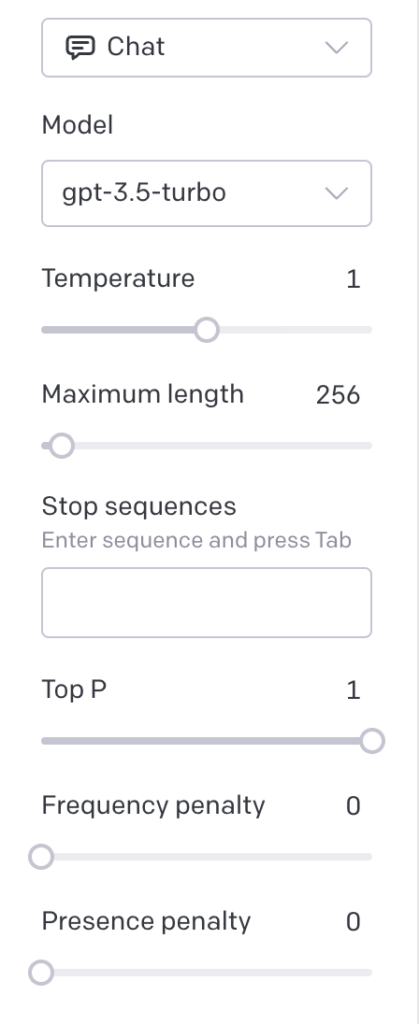

ChatGPT hat verschiedene Einstellungen, die bestimmen, wie ChatGPT das nächste Wort wählt. Diese Einstellungen kannst du im Prompt mitgeben, in den „Custom Instructions“ allgemeingültig für alle deine Prompts hinterlegen oder im Playground von OpenAI auf der rechten Seite einstellen.

Wie “kreativ” Chat GPT hierbei ist, lässt sich über den Parameter “Temperatur” festlegen. Die Temperatur reicht auf einer Skala von 0-1, wobei 0 keine Kreativität zulässt und basierend auf Wahrscheinlichkeit das nächste wort berechnet, während 1 eine hohe Kreativität bedeutet und auch weniger wahrscheinlich Wörter gewählt werden.

Bei 0,8 scheint der Text am besten zu sein, aber das ist eher Erfahrungswert als exakte Wissenschaft.

Weiterhin gibt es noch die Einstellungen Frequenzstrafe (Frequency Penalty) und Präsenzstrafe (Presence Penalty), die in der Feinabstimmung verwendet werden können, um das Verhalten und die Ausgabe des Modells zu steuern. Diese Techniken sind nützlich, um sicherzustellen, dass die generierten Antworten bestimmte Eigenschaften aufweisen oder gewünschte Muster beibehalten.

Frequenzstrafe (Frequency Penalty)

Die Frequenzstrafe bezieht sich auf die Kontrolle der Häufigkeit von bestimmten Wörtern oder Phrasen in den generierten Texten. Wenn du eine bestimmte Art von Worten oder Ausdrücken in den Antworten des Modells einschränken oder fördern möchtest, kannst du die Frequenzstrafe anwenden. Diese Strafe beeinflusst die Wahrscheinlichkeit, mit der das Modell häufig verwendete Wörter oder Phrasen in seinen Ausgaben verwendet.

Wenn du beispielsweise möchtest, dass das Modell nicht zu oft dieselbe Phrase wiederholt, könntest du eine höhere Frequenzstrafe anwenden, um die Wiederholung von Ausdrücken zu verringern.

Präsenzstrafe (Presence Penalty)

Die Präsenzstrafe bezieht sich darauf, wie stark das Modell bestimmte Wörter oder Phrasen in seinen generierten Texten verwendet. Dies wird verwendet, um die Wahrscheinlichkeit zu beeinflussen, mit der das Modell spezifische Inhalte in seine Antworten einbezieht. Wenn du beispielsweise möchtest, dass das Modell weniger häufig bestimmte Schlüsselwörter oder Konzepte verwendet, könntest du eine höhere Präsenzstrafe anwenden.

Durch die Manipulation von Frequenzstrafe und Präsenzstrafe kannst du das Verhalten des Modells in Bezug auf bestimmte Wörter, Phrasen oder Muster anpassen, um sicherzustellen, dass die generierten Antworten deinen Anforderungen entsprechen. Dies kann hilfreich sein, um unerwünschte Ausgaben zu reduzieren oder bestimmte Stile und Tonalitäten in den generierten Texten zu fördern.

Es ist wichtig zu beachten, dass die genaue Implementierung und die Auswirkungen dieser Techniken je nach Kontext und Modell variieren können. Sie sind Teil der Werkzeuge, die Entwicklern zur Verfügung stehen, um die Ausgabe von Sprachmodellen zu steuern und anzupassen.